No vasto mundo da internet, há um segredo sutil que influencia diretamente a forma como os motores de busca, como o Google, navegam pelos websites.

Esse segredo atende pelo nome de “robots.txt”, um arquivo aparentemente modesto, mas que detém o poder de determinar quais páginas da web são abertas para a compreensão dos robôs rastreadores e quais permanecem escondidas. Em suas buscas pela internet você já deve ter se perguntado o que é robots.txt ? Esse artigo te ajudará a descobrir a chave para o controle do que é visível ou invisível nos corredores digitais da informação.

À medida que você compreender esses pequenos textos, descobrirá como eles podem contribuir para o relacionamento entre seu site e os motores de busca, e por que seu conteúdo pode ser crucial para o sucesso online.

Continue a leitura e vamos entender um pouco mais.

O que é robots txt?

Todos os dias surgem novidades no campo da Inteligência Artificial. Sejam buscas feitas por voz, produção de conteúdo ou quaisquer outros elementos que ajudam no engajamento dos sites dentro do marketing digital.

Robots.txt não é muito diferente dessas inteligências, o conceito se refere a um arquivo de texto que controla o comportamento de robôs de busca (como os usados pelos motores de busca, como o Google) em um site.

Ele fornece instruções aos robôs sobre quais partes do site eles podem ou não rastrear e indexar.

Ou seja, o robots.txt é um arquivo de texto que ajuda a controlar a indexação de conteúdo e a otimizar a visibilidade nos resultados de pesquisa on-line, bem como melhorar as buscas.

Como criar robots txt?

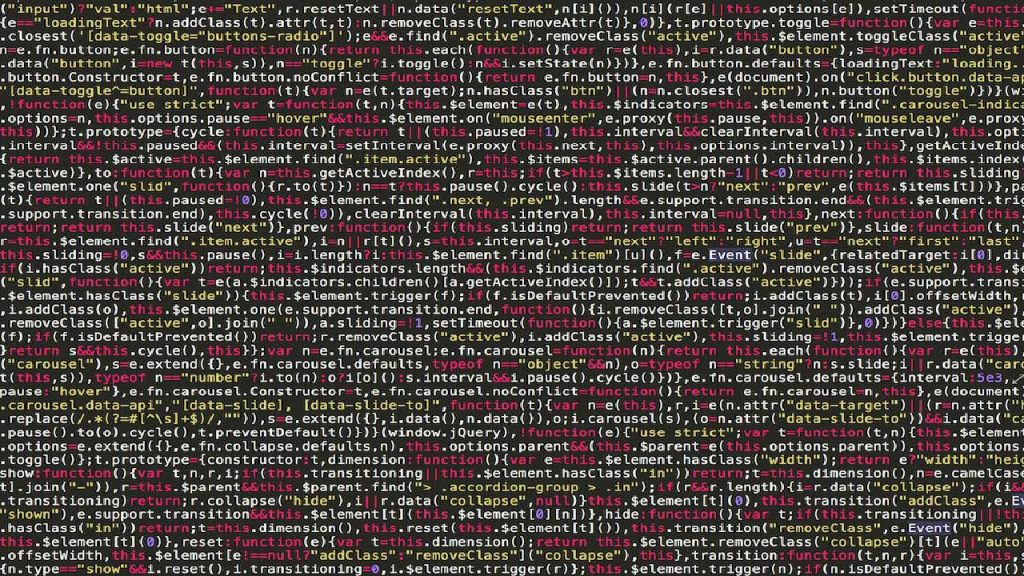

Utilize as regras para rastreamento de bots, usando “User-agent” para especificar os motores de busca e “Disallow” para bloquear diretórios ou páginas e depois carregue o arquivo na raiz do servidor do seu site para implementá-lo. Faça um arquivo de texto com o nome “robots.txtco”, assim saberá como criar robots.txt.

Veja abaixo mais termos sobre as funcionalidades dos robots.txt:

- User-agent: Aqui você especifica o robô de busca a que as instruções se aplicam. Por exemplo, “User-agent: Googlebot” direcionaria as instruções para o robô do Google.

- Disallow: Indica quais partes do site os robôs não devem rastrear. Por exemplo, “Disallow: /pasta-secreta/” impediria que os robôs rastreassem qualquer conteúdo na pasta chamada “pasta-secreta”.

- Allow: É usado para permitir o acesso a partes específicas do site, mesmo que a regra geral seja a de bloquear. Por exemplo, “Allow: /pasta-publica/” permitiria que os robôs rastreassem o conteúdo na pasta chamada “pasta-publica”.

- Crawl-delay: Define um atraso em segundos entre as solicitações do robô para evitar sobrecarregar o servidor. Por exemplo, “Crawl-delay: 5” faria com que o robô aguardasse 5 segundos entre as solicitações.

- Sitemap: Especifica a localização do sitemap do site para facilitar o rastreamento e indexação. Por exemplo, “Sitemap: https://www.exemplo.com/sitemap.xml“.

É importante observar que o arquivo “robots.txt” é uma diretriz e não uma regra. Isso porque os robôs de busca podem obedecer ou não às instruções fornecidas no arquivo.

Além disso, informações confidenciais não devem ser colocadas no arquivo “robots.txt”, uma vez que ele é de acesso público e pode ser visualizado por qualquer pessoa.

Os robôs são aliados importantes do marketing digital e auxiliam o seu site a se posicionar melhor nas páginas de busca a partir do momento que cuidam da interação entre os seus conteúdos e essas páginas.

Aproveite e confira também:

SEO Técnico: o que fazer para alavancar um site no Google?

Como começar a fazer marketing digital?

Qual a importância do robots.txt?

A importância do arquivo “robots.txt” está na sua capacidade de controlar como os motores de busca interagem com o seu site. Então, quando você se perguntar qual a importância dele, aqui estão algumas das razões pelas quais ele é crucial:

- Controle de acesso: permite que você especifique quais partes do seu site os robôs de busca podem rastrear e indexar. Isso é fundamental para proteger informações sensíveis e direcionar a atenção dos motores de busca para o conteúdo mais relevante.

- Economia de recursos: ao direcionar os robôs para as áreas apropriadas do seu site, você economiza recursos do servidor e largura de banda, já que não está permitindo que eles acessem páginas desnecessárias.

- Melhoria na indexação: usando o “robots.txt” de forma estratégica, você pode assegurar que as páginas mais importantes do seu site sejam rastreadas com prioridade, ajudando a melhorar a indexação nos motores de busca.

- SEO: é uma ferramenta importante em estratégias de otimização de mecanismos de busca (SEO). Ele pode ser usado para evitar conteúdo duplicado, focar em palavras-chave específicas e melhorar a visibilidade nos resultados de pesquisa.

- Controle de rastreamento: com ele, você pode definir a velocidade de rastreamento dos robôs, evitando sobrecargas nos servidores, especialmente em sites com muito tráfego.

- Melhoria na experiência do usuário: ao direcionar os robôs adequadamente, você pode garantir que as páginas mais relevantes e atualizadas sejam exibidas nos resultados de busca, melhorando a experiência do usuário.

Em resumo, o “robots.txt” desempenha um papel fundamental na administração e otimização do desempenho do seu site nos motores de busca, e compreender como usá-lo eficazmente pode ter um impacto significativo na visibilidade e eficácia da sua presença online.

Como funciona o arquivo robots.txt?

Mas, como funciona esse arquivo? Tenha em mente que o arquivo funciona como um mecanismo de comunicação entre o proprietário de um site e os robôs de busca, como o Googlebot, que rastreiam a web em busca de informações para indexar nos motores de busca.

A sua operação é relativamente simples, veja abaixo:

- Localização do arquivo: o arquivo “robots.txt” deve ser colocado na raiz do diretório do seu site. Ele possui um nome fixo e sempre deve ser acessível pelo caminho “https://www.seusite.com/robots.txt“.

- Estrutura do arquivo: o “robots.txt” é um arquivo de texto simples que contém diretivas específicas. Cada diretiva consiste em um ou mais campos, sendo os mais comuns os abordados no tópico “Como criar robots txt”, no presente artigo.

- Interpretação pelo robô: quando um robô de busca visita o seu site, ele verifica o arquivo “robots.txt” na raiz e analisa as diretivas. Ele respeitará as regras contidas no arquivo, ou seja, não rastreará as partes bloqueadas e seguirá as instruções de atraso ou acesso permitido conforme definido.

- Adesão opcional: é importante notar que os robôs de busca podem optar por obedecer ou não às instruções do “robots.txt”. Alguns robôs respeitam rigorosamente as regras, enquanto outros podem ignorá-las, embora a maioria dos motores de busca importantes, como o Google, siga as diretrizes.

Assim, ele é uma ferramenta útil para direcionar o rastreamento de robôs, proteger informações confidenciais e melhorar a experiência do usuário, mas não oferece uma segurança absoluta, pois depende da cooperação dos robôs de busca para ser eficaz.

Portanto, é uma parte importante da administração do seu site, mas não deve ser a única medida de segurança e controle de acesso.

Boas práticas para Robots.txt

Existem algumas boas práticas para Robots.txt que você deve seguir ao criar e gerenciar o arquivo “robots.txt” para garantir que ele funcione eficazmente e beneficie seu site. Aqui estão algumas delas:

- Use comentários descritivos: inclua comentários explicativos no arquivo “robots.txt” para que outros desenvolvedores ou administradores do site possam entender facilmente as instruções. Comentários começam com o caractere “#” e não afetam o funcionamento do arquivo.

Exemplo:

- Teste suas configurações: antes de implementar seu arquivo “robots.txt”, use ferramentas de teste de “robots.txt” fornecidas por motores de busca, como o Google Search Console, para verificar se não há erros e para ver como os robôs de busca interpretarão suas regras.

- Seja específico, mas não exagerado: seja específico nas instruções para direcionar os robôs para áreas relevantes do seu site, mas evite restringir o acesso em excesso. Um arquivo “robots.txt” muito restritivo pode impedir que seu site seja adequadamente indexado.

- Inclua um sitemap: se você tiver um sitemap (um arquivo que lista todas as páginas do seu site), inclua a diretiva “Sitemap” no “robots.txt”. Isso pode ajudar os robôs a encontrar e indexar todas as páginas do seu site.

Exemplo:

- Use a diretiva “Allow” com cautela: embora a diretiva “Allow” permita acesso a áreas específicas, ela não é reconhecida por todos os robôs de busca. Portanto, é melhor confiar principalmente na diretiva “Disallow” para bloquear o acesso a áreas sensíveis.

- Evite informações sensíveis: não coloque informações confidenciais, como senhas, no arquivo “robots.txt”. Ele é de acesso público e pode ser lido por qualquer pessoa.

- Evite bloquear páginas importantes: certifique-se de não bloquear acidentalmente páginas importantes do seu site, como a página inicial, páginas de produtos ou conteúdo relevante para SEO. Verifique seu arquivo “robots.txt” cuidadosamente para evitar bloqueios indesejados.

- Mantenha atualizado: atualize seu arquivo “robots.txt” conforme necessário para refletir as mudanças no seu site. Por exemplo, se você criar ou excluir páginas, ajuste as diretivas apropriadamente.

Lembre-se de que o arquivo “robots.txt” é uma diretriz e não uma regra muito fechada. Alguns robôs de busca podem escolher não obedecer às regras, e, portanto, a segurança do seu site não deve depender exclusivamente dele.

É importante adotar outras medidas de segurança e controle de acesso, conforme necessário.

Protocolo de exclusão de robôs

O termo “protocolo de exclusão de robôs” geralmente se refere a um conjunto de padrões e diretrizes para controlar o acesso de robôs de busca a partes específicas de um site da web.

O protocolo mais comumente usado para essa finalidade é o “Robots Exclusion Protocol” ou “robots.txt”.

O protocolo “robots.txt” permite que os proprietários de sites comuniquem suas preferências sobre o acesso de robôs a áreas específicas. Por exemplo, é usado para bloquear o acesso a informações confidenciais, evitar o rastreamento de páginas desnecessárias e direcionar o foco dos robôs para o conteúdo relevante.

Além do “robots.txt”, também existe outro protocolo de exclusão de robôs chamado “meta tag de exclusão de robôs” (ou “meta tag noindex”), que é inserido no código HTML de páginas individuais para instruir os robôs a não indexarem uma página específica.

Ambos os protocolos desempenham um papel importante na administração de sites e na otimização para mecanismos de busca, garantindo que o conteúdo seja rastreado e indexado de acordo com as preferências do proprietário do site.

Além disso, outras estratégias como, por exemplo, a criação de UTM e URL parametrizada, podem auxiliar na construção de boas comunicações entre o seu site e os motores de busca. Essa é uma forma de acompanhar de onde vem as interações.

Já está por dentro de tudo sobre robots tx?

Agora que você já compreendeu melhor o que é Robots.txt, se quiser se aprofundar mais no conceito e aplicá-lo no seu site, não deixe de falar com os nossos especialistas. A Agência Papoca é especializada em impulsionar o crescimento de negócios, concentrando-se em três pilares principais: SEO, Inbound Marketing e Growth Hacking. A missão é aumentar o tráfego, gerar leads qualificados e impulsionar as vendas.